公司新闻

谷歌搜索上线25周年!用AI升级搜索,细数25个精妙时刻|谷歌|谷歌搜索|Google

文|尚恩

编辑|邓咏仪

谷歌搜索自1997年问世以来,已经陪伴我们走过四分之一个世纪。

如今,谷歌已经从最初的网页搜索,发展成为AI新标杆。从Google Images到即将推出的最强大模型Gemini,再到那些我们尚不知晓的惊喜,谷歌一直在以AI为核心,持续为用户提供更优质的产品与服务。

25周年,是一个回顾与总结的好时机。北京时间9月27日,谷歌官方Blog登载了一篇博文——感恩用户25年来的好奇心,推动谷歌搜索的发展。

让我们先来看看在Google Search 25周岁,谷歌说了什么?

感谢用户的好奇心,谷歌搜索25岁

来源:Google

来源:Google25年前,我们启动了谷歌搜索,帮助大家找到生活中的大事小事。

如今,数十亿人都借助我们的产品满足好奇心,创业创新展开新的征程,解决“如何切菠萝”等日常问题。在这个里程碑面前,谷歌CEO桑达尔·皮查伊表示:

能够走到今天是一项巨大的荣幸,我们并非孤军奋战。

谷歌之所以成为现在的样子,是因为员工、合作伙伴,最重要的是广大用户。正是你们的好奇心激励我们不断进步。

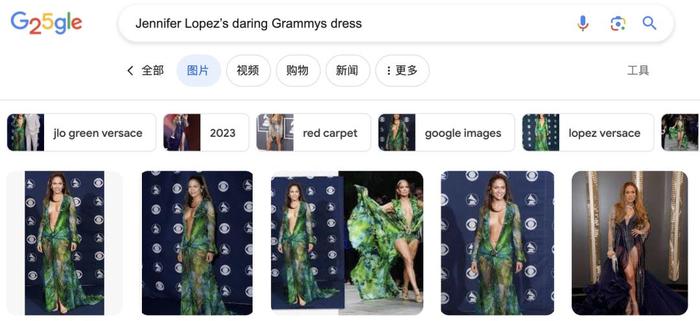

2000年,詹妮弗·洛佩兹在格莱美颁奖礼上穿了一件大胆性感的绿色礼服,引发了轰动。于是,无数网友纷纷涌向谷歌,想看看这件绿裙的照片。“詹妮弗·洛佩兹、格莱美”成为谷歌最热门的搜索词。但搜索结果只返回了10个蓝色的网页链接,并没有詹妮弗·洛佩兹穿绿裙的照片。

来源:Google

来源:Google为了解决这个问题,谷歌的工程师们昼夜不休地工作,想出了同时索引网页和图片的办法。很快,谷歌图片搜索诞生了,人们可以比以前更快地找到心仪的图片。詹妮弗·洛佩兹绿裙事件直接促成了谷歌图片搜索的产生,打开了互联网图片搜索的新篇章。

此后25年,谷歌和用户形成了相互促进的关系。不管你想学系领带还是准备结婚,我们都在你身边;不管你要保健或了解世界,我们的每一章都与你共同谱写。

为纪念生日,我们以这25年来的方式庆祝:

主页涂鸦呈现谷歌logo演变,搜索生日相关内容会有惊喜,但更重要的是,我们想说声谢谢。

我们热衷于让科技每天为你提供帮助,也受到你们用它取得成就的启发。面对机遇,我们谦虚接受AI带来的潜力,继续完成使命,改善更多人的生活。

来源:Google

来源:Google如谷歌CEO桑达尔·皮查伊所言:“我们的探索将推动未来25年非凡的科技进步,我们很荣幸与你们一起构建未来”。

25岁生日快乐,谷歌期待与你们一起迎接好奇的未来!

谷歌搜索的25个精妙时刻

搜索是谷歌的核心业务,而对AI的探索也正起源于此。在更早前的9月6日,谷歌就发布了一篇博客,细数25个搜索领域最重要的时刻——从有用的图像到人工智能,描绘出谷歌技术的演进历史。

来源:Google

来源:Google2001年:谷歌图片

当詹妮弗·洛佩兹在2000年格莱美颁奖典礼上穿着一款惊艳的范思哲裙子后,这个时装瞬时成为传奇,也成为当时谷歌最热门的搜索词。当时,搜索结果只是一列蓝色链接,人们无法轻易找到想要的图片。这启发我们创建了谷歌图片。

2001年:您是不是要找?

“您是不是要找”(Did you mean)带有拼写纠正建议,是我们早期将机器学习应用于搜索的功能之一。以前,如果您的搜索词有拼写错误(比如fluorecent),我们会帮您找到其他包含相同拼写错误的页面,这些页面通常不是您想要的最佳结果。

现在,新的基于AI技术,即使手滑也能帮您找到正确的信息。

来源:Google

来源:Google2002年:谷歌新闻

在2001年9月11日的悲剧事件中,很难及时获取信息。为满足用户对实时新闻的需求,我们在次年推出了谷歌新闻,并为每个故事提供不同新闻来源的链接。

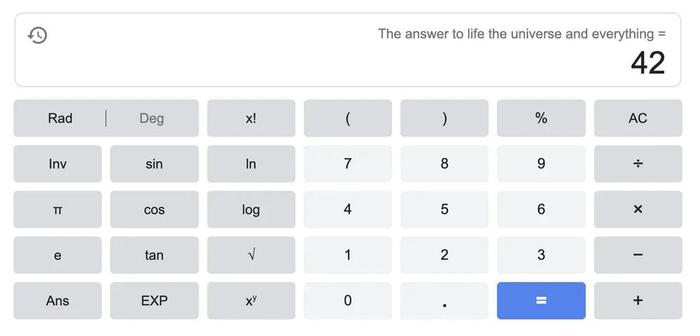

2003年:复活节彩蛋

多年来,谷歌员工在搜索中开发了许多巧妙的复活节彩蛋。2003年,我们的第一个复活节彩蛋给出了生命、宇宙及任何事物的答案,从那以后,成千上万的网民倾斜网页、做桶滚动、享受有趣的递归循环,庆祝流行文化中的重要时刻。

最早的复活节彩蛋之一至今仍可在搜索中找到,图源:谷歌

最早的复活节彩蛋之一至今仍可在搜索中找到,图源:谷歌2004年:自动完成功能

为了让打字的速度跟上思维速度,自动完成(Autocomplete)功能登场了。这一最初以“谷歌建议”出现的功能可以在输入时自动预测搜索词。现在据统计,自动完成功能减少了25%的输入时间,每天为用户节省超过200年的打字时间。

2004年:当地信息

过去,人们依赖传统电话簿查找商业信息。2004年,谷歌地方为商业列表增加了地图、路线、评论等相关信息。2011年,我们在移动端增加了点击呼叫功能,使用户可以更容易联系商家。

2006年:谷歌翻译

谷歌研究人员从2002年开始开发机器翻译技术,以消除网络上的语言障碍。四年后,我们推出了谷歌翻译(Google Translate),最初支持阿拉伯语和英语之间的文本翻译。如今,谷歌翻译支持100多种语言,仅去年就新增了24种语言。

2006年:谷歌趋势

谷歌趋势(Google Trends)的建立是为了帮助我们理解搜索趋势的数据汇总(并制作我们的年度搜索词回顾)。如今,谷歌趋势是世界上最大的免费数据集之一。

2007年:通用搜索

有用的搜索结果应该包括各种格式的相关信息,如链接、图像、视频和当地结果。因此,我们重新设计了系统,可以同时搜索所有内容类型。

2008年:谷歌手机App

随着苹果App Store的到来,我们在iPhone上推出了第一个谷歌手机App。

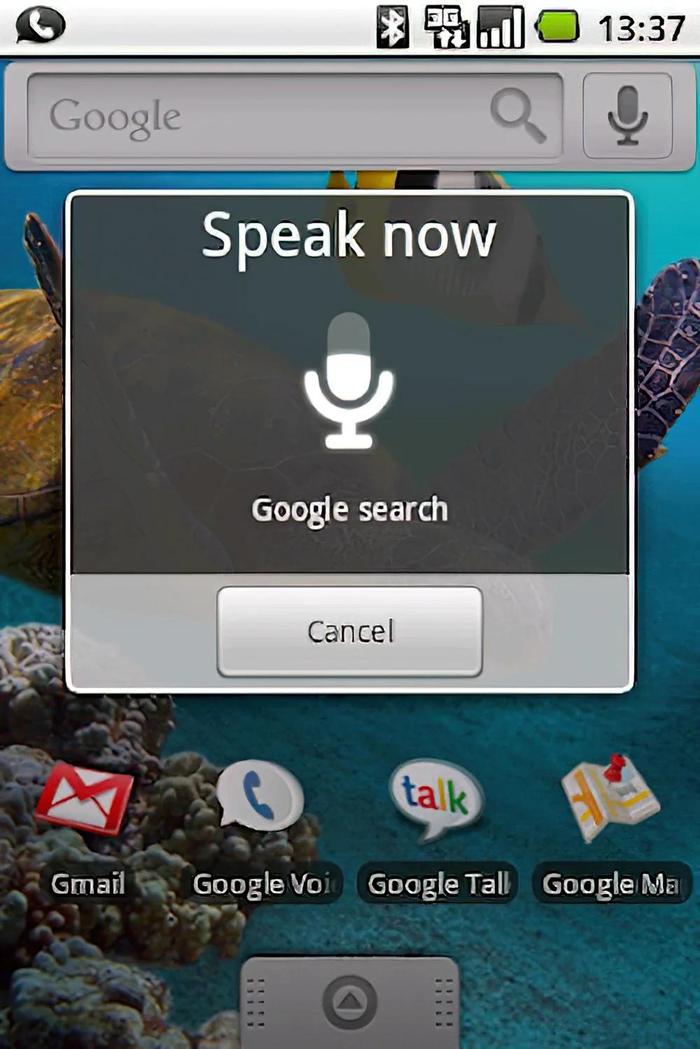

2008年:语音搜索

2008年,我们在谷歌手机App上引入语音搜索功能,2011年扩展到桌面端。通过语音搜索,人们只需点击一下就可以语音搜索。

2008年原始谷歌语音搜索移动功能,图源:谷歌

2008年原始谷歌语音搜索移动功能,图源:谷歌2009年:紧急热线

一位母亲因为女儿吞下危险物质后无法及时找到紧急热线,根据她的建议,我们在搜索结果顶部显示紧急热线(Emergency Hotlines),自此,我们在搜索结果页面顶部紧急时刻所需的热线电话。

2011年:图片搜索

因为有时候,搜索的内容很难用语言描述,我们推出了图片搜索(Search by Image),您可以上传任何图片或图片链接,找出这是什么图像以及该图像还出现在网上的其他位置。

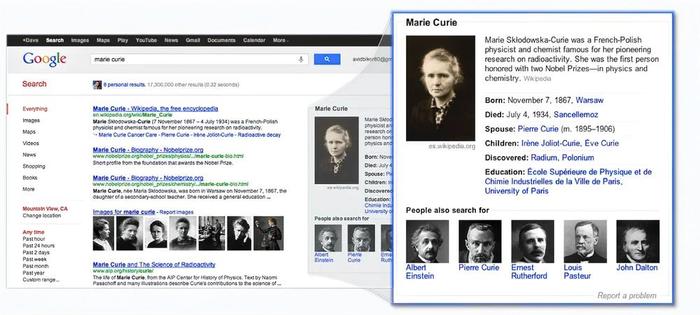

2012年:知识图谱

我们推出了知识图谱(Knowledge Graph),涵盖了众多人物、地点和事物,可以让用户快速且容易的获取答案。

居里夫人的原始知识图谱面板,图源:谷歌

居里夫人的原始知识图谱面板,图源:谷歌2015年:热门时段

我们在搜索和地图中推出了热门时段(Popular Times)功能,帮助人们了解餐馆、商店和博物馆等地点一天中最忙碌的时间段。

2016年:发现

通过推出个性化内容流,用户在谷歌App中获取针对自己兴趣内容的个性化推荐。

2017年:Lens

Google Lens将您的相机转化为一个搜索查询工具,它通过观察图片中的物体,将其与其他图片进行比较,并根据它们与原始图片的相似性和相关性对其他图片进行排名。现在,您可以在Google应用程序中搜索您所看到的东西。

如今,Lens每月处理超过120亿次视觉搜索。

使用谷歌Lens翻译车票上的文字,图源:谷歌

使用谷歌Lens翻译车票上的文字,图源:谷歌2018年:洪水预警

为帮助人们更好地准备即将到来的洪水,我们创建了预测模型,使用AI预测洪水发生的时间和地点,目前洪水预警功能已经扩展到80个国家/地区。

2019年:BERT

使搜索更有用的一个重要因素是我们理解语言的能力。2018年,我们引入并开源了一种基于神经网络训练的语言理解模型:BERT。BERT通过更好地理解语言的全部上下文来使搜索更有用。

2020年:购物图谱

当我们使任何零售商或品牌都可以免费展示其产品时,网上购物变得更全面更方便了。我们还推出了购物图谱,这是一个由不断更新的产品、卖家、品牌、评论和当地库存组成的基于AI的数据集,如今拥有350亿个产品列表。

2020年:哼一曲搜索

我们在谷歌App推出了“哼一曲搜索”(Hum to Search),当您想不起脑海里循环的旋律时,只需哼唱、嘘声或唱旋一小段旋律,AI就可以识别匹配的歌曲。

2021年:关于此结果

为了帮助人们更明智地选择哪些搜索结果对他们最有用,我们在大多数搜索结果旁边添加了“关于此结果”(About this result)的功能。它解释了为什么会显示某个结果,并根据信息素养专家的最佳实践,提供了有关内容及其来源的更多上下文信息。现在,“关于此结果”功能在所有支持搜索的语言中都可用。

2022年:多重搜索

为了帮助您找到您正在寻找的信息,我们创建了一种全新的搜索方式,通过Multisearch可以同时使用文本和图像进行搜索。现在,您可以拍摄您的餐桌照片并添加查询“咖啡桌”,以找到匹配的桌子。

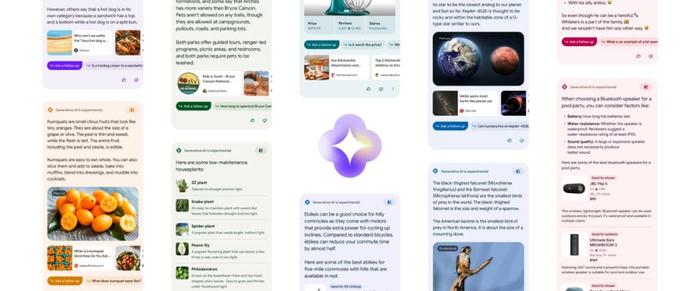

2023年:搜索实验室和生成式搜索体验(SGE)

每年在搜索领域,我们都进行了数十万次的实验,以找出如何使Google更加有益于用户的升级点。通过Search Labs,您可以测试早期实验,并直接与负责这些实验的团队分享反馈。第一个实验SGE将生成式人工智能的功能直接融入了搜索中。用户可以通过AI生成的概述了解一个主题,获得进一步探索的指引,并以自然的方式提出后续问题。

来源:Google

来源:Google谷歌CEO皮查伊曾强调,搜索依然是谷歌的核心登月计划,但是AI,则是帮助谷歌在未来十年实现其使命的关键。

布局大模型,AI升级搜索

在大模型风起云涌的当下,谷歌自然也不会坐以待毙让OpenAI出尽风头。在今年5月举行的谷歌 I/O 大会上,谷歌就推出了对标GPT-4的大模型PaLM 2,而搜索引擎侧也开始了一轮革新。

当时,谷歌宣布开放其用于测试搜索功能的新平台“Search Labs”,该平台旨在让用户提前体验和测试一些谷歌早期实验性的搜索功能和特性。通过参与Search Labs,用户可以获得先行体验并提供反馈,从而帮助谷歌改进和优化这些功能。

而在Search Labs中最有趣的功能是搜索生成体验(Search Generative Experience,SGE),它会在整个Google的搜索结果顶部放置一个由人工智能生成的摘要。

例如,当你搜索某个问题的相关答案时,以前Google给定的搜索结果是直接引导你前往维基百科或者给出10个相关的链接地址,现在不同了,Google的AI大模型会生成几段信息,并为你提供一些进一步阅读的链接。

除了SGE功能外,Search Labs还包括另外两个功能:

Add to Sheets和Code Tips。

其中,Add to Sheets功能会在搜索结果中的每个链接旁边添加一个按钮,点击该按钮将该链接添加到你选择的 Google Sheet中。Code Tips则是一个基于大语言模型的系统,专门用于帮助用户编写和修改代码。

在进入 Search Labs 后,由生成式AI驱动的搜索体验将帮助减轻搜索中的工作负担,可以更快速的理解主题,发现新的观点和见解,从而更轻松地完成任务,用户不再需要提出一系列问题并亲自拼凑信息。

来源:Google

来源:Google此外在大模型方面,除了对AI聊天机器人Bard进行更新接入Google搜索,以及增加对Gmail、Docs、Drive等应用插件的支持。

来源:Google

来源:Google谷歌新一代语言模型Gemini预计将在今年秋季揭开神秘面纱。据The Information透露,谷歌已经向小部分人开放了Gemini的访问权限,这意味着谷歌或许即将把Gemini推向消费者端。

长按添加「智涌」小助手入群

添加请备注:公司+职务?

开丰新闻

联系我们

公司名称: 开丰娱乐-开丰五金配件机电公司

手 机: 13800000000

电 话: 400-123-4567

邮 箱: admin@youweb.com

地 址: 广东省广州市天河区88号